【摘 要】 我们提供了一个新的统一视角,能够容纳所有现有的高斯过程回归的概率稀疏近似方法。我们的方法依赖于对所采用方法的有效先验(effective prior)的表达。这能够得到对这些方法的新见解,并突出现有方法之间的关系。它还允许对已知近似方法与完整高斯过程之间的接近程度进行理论上的排序。最后,我们直接给出了一种新的更好的稀疏近似设计,该设计在有吸引力的计算约束下结合了现有策略的优点。

【原 文】 Quinonero-Candela, J. and Rasmussen, C.E. (2005) ‘A unifying view of sparse approximate Gaussian process regression’, The Journal of Machine Learning Research, 6, pp. 1939–1959.

基于高斯过程 (GP) 的回归模型易于实现、灵活、完全概率模型,因此是许多应用领域中的强大工具。其主要局限性在于内存需求和计算需求分别随着训练点数量 n n n [8]

在本文中,我们提供了一种有关高斯过程回归稀疏近似的统一视角,该方法简单但功能强大: 我们分析每种算法的后验,并计算其 有效先验(effective prior) 。因此,所有稀疏近似算法都将被重新解释为 “具有近似先验的精确推断”,而不是现在常认为的 “具有精确先验的近似推断”(注: 稀疏近似方法大多采用归纳点来近似真实训练数据,实在实施后验推断之前的工作,因此常被称为属于先验近似方法)。 此方法的优点在于: 可以根据函数的先验假设直接表达近似,从而使得近似结果更容易被理解。我们对近似的看法可能不是唯一的,但它能够将现有各种概率稀疏近似都放在一个框架内,从而能够比较并揭示它们之间的关系 。

注: 作者在此处力图建立一种统一的分析视角,将所有稀疏近似方法都视为采用了近似先验后的精确推断和学习。与此相对的,是使用了近似的后验推断方法(如变分、MCMC)。因此,从某种程度上来说,本文最大的亮点在于提出了 “有效先验” 的概念,以及基于该概念形成的一个统一表达框架。此外需要注意的是,先验近似和后验近似并非非此即彼的关系,而是可以进行组合。如: 先验近似 + 精确推断、先验近似 + 变分推断 … \ldots …

本文结构:

在 第 1 节 中,我们简要介绍了用于回归的高斯过程模型。

在 第 2 节 中,我们展示了统一框架并写出了关键方程。

在 第 3 节 中,我们介绍了作为基线之一的数据子集(SoD)方法。

在 第 4-7 节 中,对各种稀疏算法提供了统一的分析。

在 第 8 节 中,介绍了转导和增广与稀疏框架的关系。

在 第 9 节 中,讨论了归纳变量的选择问题。

在 第 10 节 中,对一些特殊近似进行评论。

在最后得出结论。

1 高斯过程回归

概率回归通常表述如下:给定训练集 D = { ( x i , y i ) , i = 1 , … , n } \mathcal{D} = \{(\mathbf{x}_i, y_i), i = 1,\ldots , n\} D = {( x i , y i ) , i = 1 , … , n } n n n x i \mathbf{x}_i x i y i y_i y i x ∗ x_* x ∗ f ∗ f_* f ∗ y ∗ y_* y ∗ f ( x ) f(x) f ( x ) y y y

y i = f ( x i ) + ε i , 其中 ε i ∼ N ( 0 , σ n o i s e 2 ) (1) y_i = f(\mathbf{x}_i) + \varepsilon_i , \text{ 其中 } \varepsilon_i \sim \mathcal{N}(0, \sigma^2_{noise}) \tag{1}

y i = f ( x i ) + ε i , 其中 ε i ∼ N ( 0 , σ n o i se 2 ) ( 1 )

式中 σ n o i s e 2 \sigma^2_{noise} σ n o i se 2

【定义 1】 高斯过程 (GP) 是随机变量的集合,其中任意有限数量的随机变量集合都构成一致的联合高斯分布。

高斯过程回归是一种贝叶斯方法,它假设了一个在函数上的高斯过程先验(通常假设均值为 0 0 0

p ( f ∣ x 1 , x 2 , … , x n ) = N ( 0 , K ) (2) p(\mathbf{f}|\mathbf{x_1}, \mathbf{x_2},\ldots , \mathbf{x}_n) = \mathcal{N}(\mathbf{0, K}) \tag{2}

p ( f ∣ x 1 , x 2 , … , x n ) = N ( 0 , K ) ( 2 )

其中 f = [ f 1 , f 2 , … , f n ] ⊤ \mathbf{f} = [ f_1, f_2,\ldots,f_n]^{\top} f = [ f 1 , f 2 , … , f n ] ⊤ f i = f ( x i ) f_i = f(\mathbf{x}_i) f i = f ( x i ) K \mathbf{K} K K i j = k ( x i , x j ) K_{ij} = k(\mathbf{x}_i, \mathbf{x}_j) K ij = k ( x i , x j ) f i f_i f i 高斯过程模型和所有表达式始终是以相应输入为索引(条件)的 。

高斯过程模型并不对输入本身建模,只关心给定输入时输出的条件分布 p ( f ∗ ∣ x ∗ , D ) p(f_*|\mathbf{x_*}, \mathcal{D}) p ( f ∗ ∣ x ∗ , D )

【备注 2】 请注意:为了遵守严格的贝叶斯形式,高斯过程先验的协方差函数应当与数据无关(但可依赖于其他参数)。

正如将在后面看到的,某些近似方案严格等价于高斯过程,而另一些则不行。也就是说,先验可能仍然是多元高斯分布,但训练案例和测试案例的协方差函数可能会有不同。

【定义 3】退化高斯过程:当且仅当一个高斯过程的协方差函数具有有限数量的非零特征值时,我们称之为退化的高斯过程。

退化高斯过程对应于有限的线性(主要指针对参数的线性)模型,典型如具有多项式协方差函数的高斯过程;而非退化高斯过程则不然,典型如具有平方指数或 RBF 核函数的高斯过程。一个有限的 m m m m m m n ≫ m n \gg m n ≫ m [8]

高斯过程模型的推断和预测原理很简单:

注:此处重点建模的是 函数真实值 和 含噪声观测值 之间的关系;虽然在表达式中没有出现 x \mathbf{x} x x \mathbf{x} x

推断 :在训练隐函数值 f \mathbf{f} f f ∗ \mathbf{f}_* f ∗ p ( y ∣ f ) p(\mathbf{y|f}) p ( y∣f )

p ( f , f ∗ ∣ y ) = p ( f , f ∗ ) p ( y ∣ f ) p ( y ) (3) p( \mathbf{f}, \mathbf{f}_*| \mathbf{y}) = \frac{p(\mathbf{f}, \mathbf{f}_*)p( \mathbf{y|f})}{p(\mathbf{y})} \tag{3}

p ( f , f ∗ ∣ y ) = p ( y ) p ( f , f ∗ ) p ( y∣f ) ( 3 )

上式中,高斯过程先验为 p ( f , f ∗ ) p(\mathbf{f}, \mathbf{f}_*) p ( f , f ∗ ) p ( f , f ∗ ∣ y ) p(\mathbf{f}, \mathbf{f}_* | \mathbf{y}) p ( f , f ∗ ∣ y ) p ( y ∣ f ) p(\mathbf{y|f}) p ( y∣f )

预测 :边缘化掉上述 联合后验 中的训练集隐变量,即可产生我们关心的后验预测分布:

p ( f ∗ ∣ y ) = ∫ p ( f , f ∗ ∣ y ) d f = 1 p ( y ) ∫ p ( y ∣ f ) p ( f , f ∗ ) d f (4) p(\mathbf{f}_* | \mathbf{y}) = \int p(\mathbf{f}, \mathbf{f}_* | \mathbf{y}) d \mathbf{f} = \frac{1}{p(\mathbf{y})} \int p(\mathbf{y|f}) p(\mathbf{f}, \mathbf{f}_*) d \mathbf{f} \tag{4}

p ( f ∗ ∣ y ) = ∫ p ( f , f ∗ ∣ y ) d f = p ( y ) 1 ∫ p ( y∣f ) p ( f , f ∗ ) d f ( 4 )

或者可以换句话说:预测分布是 “高斯过程先验与似然的乘积,在归一化之后的边缘分布”。根据高斯过程定义,高斯过程先验 p ( f , f ∗ ) p(\mathbf{f}, \mathbf{f}_*) p ( f , f ∗ ) p ( y ∣ f ) p(\mathbf{y|f}) p ( y∣f )

Prior: p ( f , f ∗ ) = N ( 0 , [ K f , f K ∗ , f K f , ∗ K ∗ , ∗ ] ) Likelihood: p ( y ∣ f ) = N ( f , σ n o i s e 2 I ) \begin{align*}

\text{Prior:} \qquad p(\mathbf{f}, \mathbf{f}_*) &= \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

K_{\mathbf{f,f}} & K_{*,\mathbf{f}}\\

K_{\mathbf{f},*} & K_{*,*}

\end{bmatrix} \right ) \\

\text{Likelihood:} \qquad p(\mathbf{y|f}) &= \mathcal{N}(\mathbf{f}, \sigma^2_{noise} \mathbf{I}) \tag{5}

\end{align*}

Prior: p ( f , f ∗ ) Likelihood: p ( y∣f ) = N ( 0 , [ K f , f K f , ∗ K ∗ , f K ∗ , ∗ ] ) = N ( f , σ n o i se 2 I ) ( 5 )

其中协方差符号 K K K ∗ * ∗ f ∗ \mathbf{f}_* f ∗ I \mathbf{I} I 式(4) 中积分内的两个项都是高斯的,因此该积分具有解析形式解,进而有如下解析形式的预测分布(详情见 [8]

p ( f ∗ ∣ y ) = N ( K ∗ , f ( K f , f + σ n o i s e 2 I ) − 1 y , K ∗ , ∗ − K ∗ , f ( K f , f + σ n o i s e 2 I ) − 1 K f , ∗ ) (6) p(\mathbf{f}_* | \mathbf{y}) = \mathcal{N}(K_{*,\mathbf{f}} (K_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I})^{-1} \mathbf{y}, K_{*,*} − K_{*,\mathbf{f}} (K_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I})^{-1} K_{\mathbf{f},*} ) \tag{6}

p ( f ∗ ∣ y ) = N ( K ∗ , f ( K f , f + σ n o i se 2 I ) − 1 y , K ∗ , ∗ − K ∗ , f ( K f , f + σ n o i se 2 I ) − 1 K f , ∗ ) ( 6 )

或写成另外一种等价形式:

μ ∗ = K ∗ , f ( K f , f + σ n o i s e 2 I ) − 1 y Σ ∗ = K ∗ , ∗ − K ∗ , f ( K f , f + σ n o i s e 2 I ) − 1 K f , ∗ \begin{align*}

\boldsymbol{\mu}_* &= K_{*,\mathbf{f}} (K_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I})^{-1} \mathbf{y}\\

\boldsymbol{\Sigma}_* &= K_{*,*} − K_{*,\mathbf{f}} (K_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I})^{-1} K_{\mathbf{f},*}

\end{align*}

μ ∗ Σ ∗ = K ∗ , f ( K f , f + σ n o i se 2 I ) − 1 y = K ∗ , ∗ − K ∗ , f ( K f , f + σ n o i se 2 I ) − 1 K f , ∗

注: 再次提醒,这里的符号 f \mathbf{f} f K K K x \mathbf{x} x

上述表达式的问题在于:(1) 预测阶段:均值和方差的计算均需要对大小为 n × n n \times n n × n O ( n 3 ) \mathcal{O}(n^3) O ( n 3 ) n n n

2 新的统一观点

稀疏高斯过程方法寻求通过修改 式(5) 中的(联合)高斯过程先验 p ( f ∗ , f ) p(\mathbf{f}_*, \mathbf{f}) p ( f ∗ , f ) 式(6) 中预测的计算要求。

(1)归纳变量与增广分布

首先引入 m m m u = [ u 1 , … , u m ] ⊤ \mathbf{u} = [u_1,\ldots , u_m]^{\top} u = [ u 1 , … , u m ] ⊤ “归纳变量” 。这些隐变量就像 f \mathbf{f} f f ∗ \mathbf{f}_* f ∗ X u X_{\mathbf{u}} X u X u X_{\mathbf{u}} X u “归纳输入” )。 一般来说,在最终的预测分布中,归纳变量 u \mathbf{u} u X u X_{\mathbf{u}} X u

归纳变量可以被视为一个泛化概念,因为在其他文献中也有 “支撑点”、“活动集” 或 “伪输入” 等叫法。需要说明的是:特定的稀疏算法会以不同方式选择归纳变量;某些算法从训练集中选择某个子集作为归纳输入,而另一些则选择训练集之外的输入。关于归纳变量选择的问题参见 第 9 节,目前我们可以考虑任意的归纳变量。

由于高斯过程的一致性(或者边缘化性质),因此我们可以将原始的高斯过程先验增广至 p ( f ∗ , f , u ) p(\mathbf{f}_*, \mathbf{f,u}) p ( f ∗ , f , u ) u \mathbf{u} u p ( f ∗ , f ) p(\mathbf{f}_*, \mathbf{f}) p ( f ∗ , f )

p ( f ∗ , f ) = ∫ p ( f ∗ , f , u ) d u = ∫ p ( f ∗ , f ∣ u ) p ( u ) d u (7) p(\mathbf{f}_*, \mathbf{f}) =\int p(\mathbf{f}_*, \mathbf{f, u}) d \mathbf{u} =\int p(\mathbf{f}_*, \mathbf{f|u}) p(\mathbf{u}) d \mathbf{u} \tag{7}

p ( f ∗ , f ) = ∫ p ( f ∗ , f , u ) d u = ∫ p ( f ∗ , f∣u ) p ( u ) d u ( 7 )

上式的第二个等号只是简单地应用了概率公式。上式中积分符号内的项均为高斯的(根据归纳变量的定义,p ( u ) = N ( 0 , K u , u ) p(\mathbf{u}) = \mathcal{N}(\mathbf{0}, K_{\mathbf{u,u}}) p ( u ) = N ( 0 , K u , u )

下面,让我们开始进入能够产生几乎所有稀疏近似的一个基础框架。

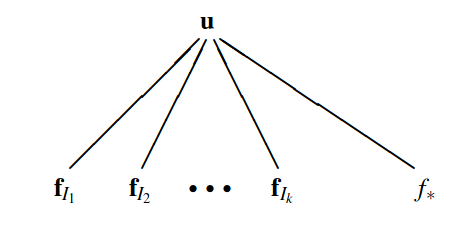

(2)训练条件与测试条件的分离

首先,为了近似联合先验,我们将对 式(7) 右侧进行分解,前提是 假设测试变量集 f ∗ \mathbf{f}_* f ∗ f \mathbf{f} f u \mathbf{u} u ,这也是本文框架必须假设的第一步,见 图 1。基于该独立性假设,式(7) 可以被近似为(此处的近似来自于假设):

p ( f ∗ , f ) ≃ q ( f ∗ , f ) = ∫ q ( f ∗ ∣ u ) q ( f ∣ u ) p ( u ) d u (8) p(\mathbf{f}_*, \mathbf{f}) \simeq q(\mathbf{f}_*, \mathbf{f}) =\int q(\mathbf{f}_*|\mathbf{u}) q( \mathbf{f|u}) p(\mathbf{u}) d \mathbf{u} \tag{8}

p ( f ∗ , f ) ≃ q ( f ∗ , f ) = ∫ q ( f ∗ ∣ u ) q ( f∣u ) p ( u ) d u ( 8 )

归纳变量的命名动机是: f \mathbf{f} f f ∗ \mathbf{f}_* f ∗ u \mathbf{u} u u \mathbf{u} u

在下文中我们将看到,各种文献中提出的稀疏近似算法,大多数都是对 式(8) 中积分内的两个近似归纳条件 q ( f ∣ u ) q(\mathbf{f|u}) q ( f∣u ) q ( f ∗ ∣ u ) q(\mathbf{f}_*|\mathbf{u}) q ( f ∗ ∣ u )

Training Conditional: p ( f ∣ u ) = N ( K f , u K u , u − 1 u , K f , f − Q f , f ) Test Conditional: p ( f ∗ ∣ u ) = N ( K ∗ , u K u , u − 1 u , K ∗ , ∗ − Q ∗ , ∗ ) \begin{align*}

&\text{Training Conditional:} \qquad &p(\mathbf{f|u}) = \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}) \tag{9a}\\

&\text{Test Conditional:} \qquad &p(\mathbf{f}_*|\mathbf{u}) = \mathcal{N}(K_{*,\mathbf{u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, K_{*,*} − Q_{*,*}) \tag{9b}

\end{align*}

Training Conditional: Test Conditional: p ( f∣u ) = N ( K f , u K u , u − 1 u , K f , f − Q f , f ) p ( f ∗ ∣ u ) = N ( K ∗ , u K u , u − 1 u , K ∗ , ∗ − Q ∗ , ∗ ) ( 9a ) ( 9b )

此处可以直接利用 式(6) 的结论,不过是一种无噪声版本,其中 u \mathbf{u} u

我们在上式中引入了简写符号 Q a , b ≜ K a , u K u , u − 1 K u , b Q_{\mathbf{a,b}} \triangleq K_{\mathbf{a,u}} K^{-1}_{\mathbf{u,u}} K_{\mathbf{u,b}} Q a , b ≜ K a , u K u , u − 1 K u , b

请注意:式(9) 中的(半正定)协方差矩阵的形式为 K − Q K − Q K − Q K K K u \mathbf{u} u f \mathbf{f} f f ∗ \mathbf{f}_* f ∗ Q Q Q

我们强调,本文中讨论的所有稀疏方法,仅对应于 式(9) 中两种条件分布的不同近似方案,并且我们自始至终都使用如下的精确似然和关于归纳变量的先验:

p ( y ∣ f ) = N ( f , σ n o i s e 2 I ) p ( u ) = N ( 0 , K u , u ) \begin{align*}

p(\mathbf{y|f}) &= \mathcal{N}(\mathbf{f}, \sigma^2_{noise}\mathbf{I}) \\

p(\mathbf{u}) &= \mathcal{N}(\mathbf{0}, K_{\mathbf{u,u}}) \tag{10}

\end{align*}

p ( y∣f ) p ( u ) = N ( f , σ n o i se 2 I ) = N ( 0 , K u , u ) ( 10 )

图 1:归纳变量 u \mathbf{u} u f = [ f 1 , … , f n ] ⊤ \mathbf{f} = [ f_1, \ldots, f_n]^{\top} f = [ f 1 , … , f n ] ⊤ f ∗ \mathbf{f}_* f ∗ y 1 , … , y n y_1, \ldots , y_n y 1 , … , y n y ∗ y_* y ∗ 式 (5) 的精确(因式分解)似然方式独立于相应的隐函数值。左图:全连接图,对应于没有对这些变量的完全联合高斯过程分布进行近似的情况。此时,归纳变量 u \mathbf{u} u u \mathbf{u} u 式 (8) 中训练条件和测试条件之间的分离。请注意, 此时训练隐函数值和测试隐函数值之间的通信路径被切断了,来自 f \mathbf{f} f u \mathbf{u} u f ∗ \mathbf{f}_* f ∗ 。

3 数据子集(SoD)近似

为便于后面的讨论,本节先介绍一种可以作为基线方法的简单稀疏近似:数据子集 (SoD) 近似。需要说明的是: 该方法不符合我们的统一框架 。

根据名字就可以知道,SoD 方法是从原始训练集中选择 m < n m < n m < n O ( m 3 ) \mathcal{O}(m^3) O ( m 3 )

图 5 左上方的子图是 SoD 的一个示例。可以看到在对随机选择的 10 10 10 n n n m m m m m m

4 回归子集 (SoR) 近似或确定性归纳条件(DIC)近似

(1)方法概述

回归子集 (SoR) 算法由 Silverman (1985 [11] [17] [12] x ∗ \mathbf{x}_* x ∗ f ∗ f_* f ∗

f ∗ = K ∗ , u w u p ( w u ) = N ( 0 , K u , u − 1 ) \begin{align*}

&f_* = K_{*,\mathbf{u}} \mathbf{w_u} \\

&p(\mathbf{w_u}) = \mathcal{N}(\mathbf{0}, K^{-1}_{\mathbf{u,u}}) \tag{11}

\end{align*}

f ∗ = K ∗ , u w u p ( w u ) = N ( 0 , K u , u − 1 ) ( 11 )

式中归纳输入集 X u X_{\mathbf{u}} X u u \mathbf{u} u u \mathbf{u} u

u = K u , u w u ⇒ ⟨ u u ⊤ ⟩ = K u , u ⟨ w u w u ⊤ ⟩ K u , u = K u , u (12) \mathbf{u} = K_{\mathbf{u,u}} \mathbf{w_u} \quad \Rightarrow \quad \langle \mathbf{u} \mathbf{u}^{\top} \rangle = K_{\mathbf{u,u}} \langle \mathbf{w_u} \mathbf{w_u}^{\top} \rangle K_{\mathbf{u,u}} = K_{\mathbf{u,u}} \tag{12}

u = K u , u w u ⇒ ⟨ u u ⊤ ⟩ = K u , u ⟨ w u w u ⊤ ⟩ K u , u = K u , u ( 12 )

使用 u \mathbf{u} u w u = K u , u − 1 u \mathbf{w_u} = K^{-1}_{\mathbf{u,u}} \mathbf{u} w u = K u , u − 1 u

f ∗ = K ∗ , u K u , u − 1 u u ∼ N ( 0 , K u , u ) \begin{align*}

&\mathbf{f}_* = K_{*,\mathbf{u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}\\

&\mathbf{u} \sim \mathcal{N}(\mathbf{0}, K_{\mathbf{u,u}}) \tag{13}

\end{align*}

f ∗ = K ∗ , u K u , u − 1 u u ∼ N ( 0 , K u , u ) ( 13 )

(2)训练条件与测试条件

推断方面 :

鉴于任何 f ∗ \mathbf{f}_* f ∗ u \mathbf{u} u 式 (8) 中积分的近似条件分布由下式给出:

q S o R ( f ∣ u ) = N ( K f , u K u , u − 1 u , 0 ) q S o R ( f ∗ ∣ u ) = N ( K ∗ , u K u , u − 1 u , 0 ) (14) q_{SoR}(\mathbf{f|u}) = \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, \mathbf{0}) \\

q_{SoR}(\mathbf{f}_*|\mathbf{u}) = \mathcal{N}(K_{*,\mathbf{u}} K^{-1}_{\mathbf{u,u}} \mathbf{u} , \mathbf{0}) \tag{14}

q S o R ( f∣u ) = N ( K f , u K u , u − 1 u , 0 ) q S o R ( f ∗ ∣ u ) = N ( K ∗ , u K u , u − 1 u , 0 ) ( 14 )

与 式(9) 相比,条件的协方差为零。

(3)先验近似

SoR 近似所隐含的先验,可以很容易通过 式(8) 推导得到:

q S o R ( f , f ∗ ) = N ( 0 , [ Q f , f Q f , ∗ Q ∗ , f Q ∗ , ∗ ] ) (15) q_{SoR}(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} & Q_{\mathbf{f},*} \\

Q_{*,\mathbf{f}} & Q_{*,*}

\end{bmatrix}

\right ) \tag{15}

q S o R ( f , f ∗ ) = N ( 0 , [ Q f , f Q ∗ , f Q f , ∗ Q ∗ , ∗ ] ) ( 15 )

回忆一下 Q Q Q Q a , b ≜ K a , u K u , u − 1 K u , b Q_{\mathbf{a,b}} \triangleq K_{\mathbf{a,u}} K^{-1}_{\mathbf{u,u}} K_{\mathbf{u,b}} Q a , b ≜ K a , u K u , u − 1 K u , b

SoR 方法也被称为 确定性归纳条件 (DIC) 近似 。此近似先验是退化的,模型中只有 m m m m m m m + 1 m + 1 m + 1 m m m

先验的退化导致不合理的预测分布。事实上,该近似先验是如此严格,以至于在给定足够数据的情况下,只有非常有限的函数族在后验函数下是合理的,这会导致过度自信的预测方差。这也是具有少量权重的有限线性模型普遍存在的问题(有关详细信息,请参阅 Rasmussen 和 Quinonero-Candela,2005 年[7] 图 5 右上图展示了 SoR 近似的预测不确定性存在一定的不合理性。

(4)预测公式 :

预测分布是通过在 式(4) 中使用 SoR 近似先验(式(15))代替真实先验而获得的。对于所有的近似方法,我们都可以给出两种形式的预测分布(相互等价),一种便于解释和理解,而另一种则计算起来更经济:

q S o R ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + σ n o i s e 2 I ) − 1 y , Q ∗ , ∗ − Q ∗ , f ( Q f , f + σ n o i s e 2 I ) − 1 Q f , ∗ ) = N ( σ − 2 K ∗ , u Σ K u , f y , K ∗ , u Σ K u , ∗ ) \begin{align*}

q_{SoR}(\mathbf{f}_* | \mathbf{y}) &= \mathcal{N}(Q_{*,\mathbf{f}} (Q_{\mathbf{f,f}} + \sigma^2_{noise} \mathbf{I})^{-1} \mathbf{y}, Q_{*,*} − Q_{*,\mathbf{f}} (Q_{\mathbf{f,f}} + \sigma^2_{noise} \mathbf{I})^{-1}Q_{\mathbf{f},*} ) \tag{16a}\\

&= \mathcal{N}(\sigma^{-2} K_{*,\mathbf{u}} \Sigma K_{\mathbf{u,f}} \mathbf{y}, K_{*,\mathbf{u}} \Sigma K_{\mathbf{u},*} ) \tag{16b}

\end{align*}

q S o R ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + σ n o i se 2 I ) − 1 y , Q ∗ , ∗ − Q ∗ , f ( Q f , f + σ n o i se 2 I ) − 1 Q f , ∗ ) = N ( σ − 2 K ∗ , u Σ K u , f y , K ∗ , u Σ K u , ∗ ) ( 16a ) ( 16b )

其中 Σ = ( σ − 2 K u , f K f , u + K u , u ) − 1 \Sigma = (\sigma^{-2} K_{\mathbf{u,f}} K_{\mathbf{f,u}} + K_{\mathbf{u,u}})^{-1} Σ = ( σ − 2 K u , f K f , u + K u , u ) − 1

式 (16a) 很容易被识别为 式 (6) 的常规预测公式,只是协方差 K K K 式(15) 中提出的 Q Q Q k S o R ( x i , x j ) = k ( x i , u ) K u , u − 1 k ( u , x j ) k_{SoR}(\mathbf{x}_i, \mathbf{x}_j) = k(\mathbf{x}_i, u) K^{-1}_{\mathbf{u,u}} k(u, \mathbf{x}_j) k S o R ( x i , x j ) = k ( x i , u ) K u , u − 1 k ( u , x j ) k k k m m m

【备注 4】 SoR 近似等价于具有协方差函数 k S o R ( x i , x j ) = k ( x i , u ) K u , u − 1 k ( u , x j ) k_{SoR}(\mathbf{x}_i, \mathbf{x}_j) = k(\mathbf{x}_i, \mathbf{u}) K^{-1}_{\mathbf{u,u}} k(\mathbf{u}, \mathbf{x}_j) k S o R ( x i , x j ) = k ( x i , u ) K u , u − 1 k ( u , x j )

式(16b) 在计算上更便宜。考虑到 式(11),Σ \Sigma Σ w u \mathbf{w_u} w u O ( n m 2 ) \mathcal{O}(nm^2) O ( n m 2 ) O ( m ) \mathcal{O}(m) O ( m ) O ( m 2 ) \mathcal{O}(m^2) O ( m 2 )

5 确定性训练条件 (DTC) 近似

(1)方法概述

借鉴 Csato 和 Opper (2002 [2] [10] 投影隐变量 (Projected Latent Variables,PLV) 高斯过程回归的稀疏近似方法,该方法不受 SoR 近似的不合理预测不确定性影响,但却能够产生完全相同的预测均值。Seeger 等(2003 [10] f = K f , u K u , u − 1 u \mathbf{f} = K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u} f = K f , u K u , u − 1 u

p ( y ∣ f ) ≃ q ( y ∣ u ) = N ( K f , u K u , u − 1 u , σ n o i s e 2 I ) (17) p(\mathbf{y|f}) \simeq q(\mathbf{y|u}) = \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, \sigma^2_{noise} \mathbf{I}) \tag{17}

p ( y∣f ) ≃ q ( y∣u ) = N ( K f , u K u , u − 1 u , σ n o i se 2 I ) ( 17 )

(2)训练条件与测试条件

该方法也被 Rasmussen 和 Williams(2006 年[8] 投影过程近似法 (Projected Process Approximation, PPA) 。获得等效模型的一种方法是保留通常的似然,但强加确定性训练条件和 式 (9b) 的精确测试条件。

q D T C ( f ∣ u ) = N ( K f , u K u , u − 1 u , 0 ) q D T C ( f ∗ ∣ u ) = p ( f ∗ ∣ u ) \begin{align*}

q_{DTC}(\mathbf{f|u}) &= \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u,0})\\

q_{DTC}(\mathbf{f}_*| \mathbf{u}) &= p(\mathbf{f}_*| \mathbf{u}) \tag{18}

\end{align*}

q D TC ( f∣u ) q D TC ( f ∗ ∣ u ) = N ( K f , u K u , u − 1 u , 0 ) = p ( f ∗ ∣ u ) ( 18 )

这种重新表述的优点是允许我们坚持我们对具有近似先验的精确推断(具有精确似然)的观点。实际上,在该模型下,给定 u \mathbf{u} u f \mathbf{f} f 式(14) 左侧给出的 SoR 的条件分布相同。这种近似的系统名称是 确定性训练条件 (DTC) 。

与 SoR 的根本区别在于: DTC 使用 式(9b) 精确测试条件,而不是 SoR 的 f ∗ \mathbf{f}_* f ∗ u \mathbf{u} u 。

(3)先验近似

DTC 隐含的联合先验由下式给出:

q D T C ( f , f ∗ ) = N ( 0 , [ Q f , f Q f , ∗ Q ∗ , f K ∗ , ∗ ] ) (19) q_{DTC}(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left ( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} & Q_{\mathbf{f},*} \\

Q_{*,\mathbf{f}} & K_{*,*}

\end{bmatrix} \right ) \tag{19}

q D TC ( f , f ∗ ) = N ( 0 , [ Q f , f Q ∗ , f Q f , ∗ K ∗ , ∗ ] ) ( 19 )

这与 SoR 近似 式(15) 隐含的有效先验惊人地相似。根本区别在于,在 DTC 近似下,f ∗ \mathbf{f}_* f ∗ K ∗ , ∗ K_{*,*} K ∗ , ∗ 图 5 的说明。

(4)预测公式

预测分布现在由下式给出:

q D T C ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + σ n o i s e 2 I ) − 1 y , K ∗ , ∗ − Q ∗ , f ( Q f , f + σ n o i s e 2 I ) − 1 Q f , ∗ = N ( σ − 2 K ∗ , u Σ K u , f y , K ∗ , ∗ − Q ∗ , ∗ + K ∗ , u Σ K ∗ , u ⊤ ) \begin{align*}

q_{DTC}(\mathbf{f}_* | \mathbf{y}) &= \mathcal{N}(Q_{*,\mathbf{f}} (Q_{\mathbf{f,f}} + \sigma^2_{noise} \mathbf{I})^{-1} \mathbf{y}, K_{*,*} − Q_{*,\mathbf{f}} (Q_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I})^{-1} Q_{\mathbf{f},*} \tag{20a}\\

&= \mathcal{N}(\sigma^{-2} K_{*,\mathbf{u}} \Sigma K_{\mathbf{u,f}} \mathbf{y}, K_{*,*} − Q_{*,*} + K_{*,\mathbf{u}} \Sigma K^{\top}_{*,\mathbf{u}} ) \tag{20b}

\end{align*}

q D TC ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + σ n o i se 2 I ) − 1 y , K ∗ , ∗ − Q ∗ , f ( Q f , f + σ n o i se 2 I ) − 1 Q f , ∗ = N ( σ − 2 K ∗ , u Σ K u , f y , K ∗ , ∗ − Q ∗ , ∗ + K ∗ , u Σ K ∗ , u ⊤ ) ( 20a ) ( 20b )

我们再次使用了 式(16) 中定义的 Σ = ( σ − 2 K u , f K f , u + K u , u ) − 1 \Sigma = (\sigma^{-2} K_{\mathbf{u,f}} K_{\mathbf{f,u}} + K_{\mathbf{u,u}})^{-1} Σ = ( σ − 2 K u , f K f , u + K u , u ) − 1 式(16)) 一致,但预测方差将 SoR 中的 Q ∗ , ∗ Q_{*,*} Q ∗ , ∗ K ∗ , ∗ K_{*,*} K ∗ , ∗ K ∗ , ∗ − Q ∗ , ∗ K_{*,*} − Q_{*,*} K ∗ , ∗ − Q ∗ , ∗ f ∗ \mathbf{f}_* f ∗ u \mathbf{u} u x ∗ \mathbf{x}_* x ∗ X u X_{\mathbf{u}} X u K ∗ , ∗ K_{*,*} K ∗ , ∗

【备注 5】 DTC 和 SoR 的预测分布之间的唯一区别是方差。 DTC 的预测方差绝不会小于 SoR。请注意,由于训练案例和测试案例的协方差的计算方式不同,参见 式 (19)

【备注 6】 DTC 近似并不精确对应于一个高斯过程 ,因为隐值之间的协方差取决于它们是训练案例还是测试案例,这违反了一致性,请参见定义 1。DTC 近似的计算复杂度具有与 SoR 方法相同的阶数。

6 完全独立条件训练 (FITC) 近似

(1)方法概述

最近,Snelson 和 Ghahramani (2006 [13] 式(17) 给出的似然近似,但 SGPP 方法提出了一种更复杂的似然近似,具有更丰富的协方差

p ( y ∣ f ) ≃ q ( y ∣ u ) = N ( K f , u K u , u − 1 u , diag [ K f , f − Q f , f ] + σ n o i s e 2 I ) (21) p(\mathbf{y|f}) \simeq q(\mathbf{y|u}) = \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u ,u}} \mathbf{u}, \text{diag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}] + \sigma^2_{noise} \mathbf{I}) \tag{21}

p ( y∣f ) ≃ q ( y∣u ) = N ( K f , u K u , u − 1 u , diag [ K f , f − Q f , f ] + σ n o i se 2 I ) ( 21 )

其中 diag [ A ] \text{diag}[A] diag [ A ] A A A

(2)训练条件与测试条件

正如我们在 式(18) 中为 DTC 所做的那样,我们提供了一个替代的等效公式,称为基于归纳条件的 完全独立训练条件 (FITC):

q F I T C ( f ∣ u ) = ∏ i = 1 n p ( f i ∣ u ) = N ( K f , u K u , u − 1 u , diag [ K f , f − Q f , f ] ) q F I T C ( f ∗ ∣ u ) = p ( f ∗ ∣ u ) \begin{align*}

q_{FITC}( \mathbf{f|u}) &= \prod^{n}_{i=1} p( f_i| \mathbf{u}) = \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, \text{diag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}]) \\

q_{FITC}( \mathbf{f}_*|\mathbf{u}) &= p ( \mathbf{f}_*|\mathbf{u}) \tag{22}

\end{align*}

q F I TC ( f∣u ) q F I TC ( f ∗ ∣ u ) = i = 1 ∏ n p ( f i ∣ u ) = N ( K f , u K u , u − 1 u , diag [ K f , f − Q f , f ]) = p ( f ∗ ∣ u ) ( 22 )

我们看到,与 SoR 和 DTC 不同,FITC 并未在 f \mathbf{f} f u \mathbf{u} u u \mathbf{u} u f \mathbf{f} f 式(22) 中使用了 式(9b) 中的精确测试条件,尽管其原因将在本节末尾变得清晰,我们最初只考虑一个测试案例 f ∗ \mathbf{f}_* f ∗ 图 2 给出了相应的图模型。

(3)先验近似

FITC 隐含的有效先验由下式给出:

q F I T C ( f , f ∗ ) = N ( 0 , [ Q f , f − diag [ Q f , f − K f , f ] Q f , ∗ Q ∗ , f K ∗ , ∗ ] ) (23) q_{FITC}(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} − \text{diag}[Q_{\mathbf{f,f}} − K_{\mathbf{f,f}}] & Q_{\mathbf{f},*} \\

Q_{*,\mathbf{f}} & K_{*,*}

\end{bmatrix} \right) \tag{23}

q F I TC ( f , f ∗ ) = N ( 0 , [ Q f , f − diag [ Q f , f − K f , f ] Q ∗ , f Q f , ∗ K ∗ , ∗ ] ) ( 23 )

图 2:FITC 近似的图形模型。与图 1 中的那些相比,隐函数值之间的所有边缘都已被删除:隐函数值在给定诱导变量 u \mathbf{u} u f \mathbf{f} f u \mathbf{u} u

(4)预测公式

请注意,DTC 和 FITC 之间的唯一区别在于先验协方差矩阵的的左上角,FITC 用对角线上的精确协方差替换了 DTC 的近似协方差。预测分布为

q F I T C ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + Λ ) − 1 y , K ∗ , ∗ − Q ∗ , f ( Q f , f + Λ ) − 1 Q f , ∗ ) = N ( K ∗ , u Σ K u , f Λ − 1 y , K ∗ , ∗ − Q ∗ , ∗ + K ∗ , u Σ K u , ∗ ) \begin{align*}

q_{FITC}( \mathbf{f}_* | \mathbf{y}) &= \mathcal{N}(Q_{*,\mathbf{f}}(Q_{\mathbf{f,f}} + \Lambda)^{-1} \mathbf{y}, K_{*,*} − Q_{*,\mathbf{f}} (Q_{\mathbf{f,f}} + \Lambda)^{-1} Q_{\mathbf{f},*}) \tag{24a} \\

&= \mathcal{N}(K_{*,\mathbf{u}} \Sigma K_{\mathbf{u,f}} \Lambda^{−1} \mathbf{y}, K_{*,*} − Q_{*,*} + K_{*,\mathbf{u}} \Sigma K_{\mathbf{u},*} ) \tag{24b}

\end{align*}

q F I TC ( f ∗ ∣ y ) = N ( Q ∗ , f ( Q f , f + Λ ) − 1 y , K ∗ , ∗ − Q ∗ , f ( Q f , f + Λ ) − 1 Q f , ∗ ) = N ( K ∗ , u Σ K u , f Λ − 1 y , K ∗ , ∗ − Q ∗ , ∗ + K ∗ , u Σ K u , ∗ ) ( 24a ) ( 24b )

其中我们定义了 Σ = ( K u , u + K u , f Λ − 1 K f , u ) − 1 \Sigma = (K_{\mathbf{u,u}} + K_{\mathbf{u,f}} \Lambda^{-1}K_{\mathbf{f,u}})^{-1} Σ = ( K u , u + K u , f Λ − 1 K f , u ) − 1 Λ = diag [ K f , f − Q f , f + σ n o i s e 2 I ] \Lambda = \text{diag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I}] Λ = diag [ K f , f − Q f , f + σ n o i se 2 I ]

联合预测问题与完全独立测试条件 到目前为止,我们只考虑了一个测试案例的情况。联合预测有两种选择:

使用来自 式(9b) 的完全测试条件;

将因子分解假设扩展到测试条件。

尽管 Snelson 和 Ghahramani (2006 [13]

【备注 7】 如果将完全独立假设扩展到测试条件,则 FITC 近似等效于具有协方差函数 k F I C ( x i , x j ) = k S o R ( x i , x j ) + δ i , j [ k ( x i , x j ) − k S o R ( x i , x j ) ] k_{FIC}(\mathbf{x}_i, \mathbf{x}_j) = k_{SoR}(\mathbf{x}_i, \mathbf{x}_j) + \delta_{i,j} [k(\mathbf{x}_i, \mathbf{x}_j) − k_{SoR}(\mathbf{x}_i, \mathbf{x}_j)] k F I C ( x i , x j ) = k S o R ( x i , x j ) + δ i , j [ k ( x i , x j ) − k S o R ( x i , x j )]

其中 δ i , j \delta_{i,j} δ i , j

q F I C ( f , f ∗ ) = N ( 0 , [ Q f , f − diag [ Q f , f − K f , f ] Q f , ∗ Q ∗ , f Q ∗ , ∗ − diag [ Q ∗ , ∗ − K ∗ , ∗ ] ] ) (25) q_{FIC}(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} − \text{diag}[Q_{\mathbf{f,f}} − K_{\mathbf{f,f}}] & Q_{\mathbf{f},*} \\

Q_{*,\mathbf{f}} & Q_{*,*} − \text{diag}[Q ∗,∗ − K_{*,*}]

\end{bmatrix} \right) \tag{25}

q F I C ( f , f ∗ ) = N ( 0 , [ Q f , f − diag [ Q f , f − K f , f ] Q ∗ , f Q f , ∗ Q ∗ , ∗ − diag [ Q ∗ , ∗ − K ∗ , ∗ ] ] ) ( 25 )

7 部分独立训练条件 (PITC) 近似

(1)训练条件与测试条件

在上一节中,我们看到了如通过独立分布(即具有对角协方差矩阵的训练条件)来近似训练条件,进而改进了 DTC 近似。在本节中,我们将通过将训练条件扩展为具有块对角线协方差矩阵,来进一步改进近似(同时保持计算上的吸引力):

q P I T C ( f ∣ u ) = N ( K f , u K u , u − 1 u , blockdiag [ K f , f − Q f , f ] ) q P I T C ( f ∗ ∣ u ) = p ( f ∗ ∣ u ) \begin{align*}

q_{PITC}(\mathbf{f|u}) &= \mathcal{N}(K_{\mathbf{f,u}} K^{-1}_{\mathbf{u,u}} \mathbf{u}, \text{blockdiag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}])\\

q_{PITC}(\mathbf{f}_*|\mathbf{u}) &= p(\mathbf{f}_*|\mathbf{u}) \tag{26}

\end{align*}

q P I TC ( f∣u ) q P I TC ( f ∗ ∣ u ) = N ( K f , u K u , u − 1 u , blockdiag [ K f , f − Q f , f ]) = p ( f ∗ ∣ u ) ( 26 )

其中 blockdiag [ A ] \text{blockdiag}[A] blockdiag [ A ] 图 3 中以图方式表示 PITC 近似。

(2)先验近似

将其类似于上一节中的 FITC 近似进行开发,我们得到联合先验

q P I T C ( f , f ∗ ) = N ( 0 , [ Q f , f − blockdiag [ Q f , f − K f , f ] Q f , ∗ Q ∗ , f K ∗ , ∗ ] ) (27) q_{PITC}(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} − \text{blockdiag}[Q_{\mathbf{f,f}} − K_{\mathbf{f,f}}] & Q_{\mathbf{f},*}\\

Q_{*,\mathbf{f}} & K_{*,*}

\end{bmatrix} \right) \tag{27}

q P I TC ( f , f ∗ ) = N ( 0 , [ Q f , f − blockdiag [ Q f , f − K f , f ] Q ∗ , f Q f , ∗ K ∗ , ∗ ] ) ( 27 )

(3)预测公式

并且预测分布与 式(24) 相同,除了 Λ = blockdiag [ K f , f − Q f , f + σ n o i s e 2 I ] \Lambda = \text{blockdiag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I} ] Λ = blockdiag [ K f , f − Q f , f + σ n o i se 2 I ] [9] [15] X u X_{\mathbf{u}} X u

重要的是要认识到 BCM 提出了两个正交思想:

首先,部分独立训练条件的块对角线结构;

其次,将归纳输入设置为测试输入。

这两个想法可以独立使用,在 第 8 节 中我们建议使用第一个而不使用第二个。

PITC 近似的计算复杂度取决于 式(26) 中强加的分块结构。 Tresp (2000) 也推荐选择 k = n / m k = n/m k = n / m m × m m \times m m × m O ( n m 2 ) \mathcal{O}(nm^2) O ( n m 2 )

【备注 8】 PITC 近似并不完全对应于一个高斯过程。

这是因为计算协方差时需要知道点是来自训练集还是测试集,式(27)。通过将部分条件独立假设扩展到测试条件,可以从 PITC 获得高斯过程,就像我们在 【备注 7】 中为 FITC 所做的那样。

图 3:PITC 近似的图形表示。由一组索引 I i I_i I i f I i \mathbf{f}_{I_i} f I i k k k 式(26) 中给出的真实训练条件的块对角线近似。

8 转导和增广

暂略。

9 关于归纳变量的选择

(1)现状

到目前为止,我们一直假设归纳输入 X u X_{\mathbf{u}} X u [1] X u X_{\mathbf{u}} X u

考虑到这中间涉及组合优化问题,有人建议采用贪心优化方法来选择归纳变量,其中涉及各种选择准则,如: 在线学习(Csato 和 Opper,2002 年 [2] [12] [10] [3]

最近,Snelson 和 Ghahramani (2006 [13]

(2)基本方法

到底应该使用哪个最优准则来选择归纳输入呢?

与完全贝叶斯方法不同(其中涉及 X u X_{\mathbf{u}} X u X u X_{\mathbf{u}} X u [13]

q ( y ∣ X u ) = ∫ ∫ p ( y ∣ f ) q ( f ∣ u ) p ( u ∣ X u ) d u d f = ∫ p ( y ∣ f ) q ( f ∣ X u ) d f (29) q(\mathbf{y}|X_{\mathbf{u}}) = \int \int p(\mathbf{y|f}) q(\mathbf{f|u}) p(\mathbf{u}|X_{\mathbf{u}})d \mathbf{u} d \mathbf{f} =\int p(\mathbf{y|f}) q(\mathbf{f}|X_{\mathbf{u}}) d \mathbf{f} \tag{29}

q ( y ∣ X u ) = ∫∫ p ( y∣f ) q ( f∣u ) p ( u ∣ X u ) d u d f = ∫ p ( y∣f ) q ( f ∣ X u ) d f ( 29 )

这与测试条件无关。我们在上面的等式中明确地以归纳输入 X u X_{\mathbf{u}} X u f \mathbf{f} f σ n o i s e 2 I \sigma^2_{noise}\mathbf{I} σ n o i se 2 I Λ \Lambda Λ

log q ( y ∣ X u ) = − 1 2 log ∣ Q f , f + Λ ∣ − 1 2 y ⊤ ( Q f , f + Λ ) − 1 y − n 2 log ( 2 π ) (30) \log q(\mathbf{y}|X_{\mathbf{u}}) = − \frac{1}{2} \log |Q_{\mathbf{f,f}} + \Lambda| − \frac{1}{2} \mathbf{y}^{\top} (Q_{\mathbf{f,f}} + \Lambda)^{-1} \mathbf{y} − \frac{n}{2} \log(2π) \tag{30}

log q ( y ∣ X u ) = − 2 1 log ∣ Q f , f + Λ∣ − 2 1 y ⊤ ( Q f , f + Λ ) − 1 y − 2 n log ( 2 π ) ( 30 )

其中 Λ S o R = Λ D T C = σ n o i s e 2 I \Lambda_{SoR} = \Lambda_{DTC} = \sigma^2_{noise}\mathbf{I} Λ S o R = Λ D TC = σ n o i se 2 I Λ F I T C = diag [ K f , f − Q f , f ] + σ n o i s e 2 I \Lambda_{FITC} = \text{diag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}] + \sigma^2_{noise}\mathbf{I} Λ F I TC = diag [ K f , f − Q f , f ] + σ n o i se 2 I Λ P I T C = blockdiag [ K f , f − Q f , f ] + σ n o i s e 2 I \Lambda_{PITC} = \text{blockdiag}[K_{\mathbf{f,f}} − Q_{\mathbf{f,f}}] + \sigma^2_{noise}\mathbf{I} Λ P I TC = blockdiag [ K f , f − Q f , f ] + σ n o i se 2 I

所有方法的边缘似然计算成本都是 O ( n m 2 ) \mathcal{O}(nm^2) O ( n m 2 ) X u X_{\mathbf{u}} X u O ( n m ) \mathcal{O}(nm) O ( nm ) X u X_{\mathbf{u}} X u O ( d n m 2 ) \mathcal{O}(dnm^2) O ( d n m 2 ) d d d

有人提议最大化有效后验而不是有效边缘似然(Smola 和 Bartlett,2001 [12] [5]

传统上,边缘似然主要用于学习高斯过程的超参数(即对超参数不强求获得分布,是一种非完全贝叶斯的处理,参见 Williams 和 Rasmussen,1996 [18] X u X_{\mathbf{u}} X u [10]

10 其他方法

在本节中,简要提及两个不适合我们统一框架的近似,其中一个不对应于适当的概率模型,另一个则使用了协方差函数的特殊构造。

10.1 Nystrom 近似

用于加速高斯过程回归的 Nystrom 近似最初由 Williams 和 Seeger (2001 [20] [19] f \mathbf{f} f Q f , f Q_{\mathbf{f,f}} Q f , f f ∗ f_* f ∗ f \mathbf{f} f f \mathbf{f} f

q ( f , f ∗ ) = N ( 0 , [ Q f , f K f , ∗ K ∗ , f K ∗ , ∗ ] ) (31) q(\mathbf{f}, \mathbf{f}_*) = \mathcal{N} \left( \mathbf{0}, \begin{bmatrix}

Q_{\mathbf{f,f}} & K_{\mathbf{f},*} \\

K_{*,\mathbf{f}} & K_{*,*}

\end{bmatrix} \right) \tag{31}

q ( f , f ∗ ) = N ( 0 , [ Q f , f K ∗ , f K f , ∗ K ∗ , ∗ ] ) ( 31 )

因此,我们无法从统一框架中派生出这种方法,也无法用图模型来表示它。更糟糕的是,生成的先验协方差矩阵甚至不能保证是正定的,因此预测方差有可能为负。请注意,将 式 (31) 中的 K f , ∗ K_{\mathbf{f},*} K f , ∗ Q f , ∗ Q_{\mathbf{f},*} Q f , ∗

【备注 14】 Nystrom 近似不对应于形式良好的概率模型 。忽略任何关于正定性的争论,Nystrom 近似的预测分布由下式给出:

p ( f ∗ ∣ y ) = N ( K f , ∗ ⊤ [ Q f , f + σ n o i s e 2 I ] − 1 y , K ∗ , ∗ − K f , ∗ ⊤ [ Q f , f + σ n o i s e 2 I ] − 1 K f , ∗ ) (32) p(f_* | \mathbf{y}) = \mathcal{N}(K^{\top}_{\mathbf{f},*} [Q_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I}]^{−1} \mathbf{y}, K_{*,*} − K^{\top}_{\mathbf{f},*} [Q_{\mathbf{f,f}} + \sigma^2_{noise}\mathbf{I}]^{−1} K_{\mathbf{f},*}) \tag{32}

p ( f ∗ ∣ y ) = N ( K f , ∗ ⊤ [ Q f , f + σ n o i se 2 I ] − 1 y , K ∗ , ∗ − K f , ∗ ⊤ [ Q f , f + σ n o i se 2 I ] − 1 K f , ∗ ) ( 32 )

但预测方差不能保证为正。计算成本为 O ( n m 2 ) \mathcal{O}(nm^2) O ( n m 2 )

10.2 相关向量机

由 Tipping (2001 [14] x ∗ \mathbf{x}_* x ∗

f ∗ = ϕ ∗ w , 其中 p ( w ∣ A ) = N ( 0 , A ) (33) \mathbf{f}_* = \phi_* \mathbf{w}, \text{ 其中 } p(\mathbf{w}|A) = \mathcal{N}(0, A) \tag{33}

f ∗ = ϕ ∗ w , 其中 p ( w ∣ A ) = N ( 0 , A ) ( 33 )

其中 ϕ ∗ = [ ϕ 1 ( x ) , … , ϕ m ( x ) ] \phi_* = [\phi_1(\mathbf{x}),\ldots , \phi_m(\mathbf{x})] ϕ ∗ = [ ϕ 1 ( x ) , … , ϕ m ( x )] m m m A = diag ( α 1 , … , α m ) A = \text{diag}( \boldsymbol{\alpha}_1,\ldots , \boldsymbol{\alpha}_m) A = diag ( α 1 , … , α m ) α i \boldsymbol{\alpha}_i α i 式(1)),并且对于足够丰富的基函数集的典型情况,许多精度达到无穷大有效地剪掉相应的权重(有关非常有趣的分析,请参见 Wipf 等,2004 年[21]

请注意,由于 RVM 是一个有限线性模型,其权重具有高斯先验,因此可以将其视为高斯过程:

【备注 15】 RVM 等价于具有如下协方差函数的退化高斯过程

k R V M ( x i , x j ) = ϕ i A − 1 ϕ j ⊤ = ∑ k = 1 m α k − 1 ϕ k ( x i ) ϕ k ( x j ) k_{RVM}(\mathbf{x}_i, \mathbf{x}_j) = \phi_i A^{−1} \phi_j^{\top} = \sum^{m}_{k=1} \boldsymbol{\alpha}^{−1}_k \phi_k(\mathbf{x}_i) \phi_k(\mathbf{x}_j)

k R V M ( x i , x j ) = ϕ i A − 1 ϕ j ⊤ = k = 1 ∑ m α k − 1 ϕ k ( x i ) ϕ k ( x j )

表 1:构建近似的方式总结。所有这些方法都在前面的部分中进行了详细介绍。每个测试案例的初始成本以及均值和方差的成本分别为精确 GP 的 n 2 n^2 n 2 n n n n 2 n^2 n 2 n m 2 nm^2 n m 2 m m m m 2 m^2 m 2

正如 Tipping (2001 [14] 第 4 节中介绍)完全相同的方式退化的高斯过程,RVM 也确实存在不合理的预测方差。 Rasmussen 和 Quinonero-Candela (2005 [7] 第 8 节。一旦学习了 α i \boldsymbol{\alpha}_i α i m m m O ( m ) \mathcal{O}(m) O ( m ) O ( m 2 ) \mathcal{O}(m^2) O ( m 2 )

RVM 通常与以训练输入为中心的径向基函数一起使用。 RVM 的一个可能有趣的扩展是学习基函数中心的位置,其方式与 Snelson 和 Ghahramani (2006 [13] 第 6 节。这是对学习的一种好奇回忆RBF 网络中的中心。

11 结论

我们为高斯回归过程的稀疏近似提供了一个统一框架。我们的方法包括两个步骤, 1) 我们根据对先验的近似重铸近似,2) 我们引入归纳变量 u \mathbf{u} u u \mathbf{u} u 表 1 的总结。

以前的方法是基于不同的近似范式(例如似然近似、投影方法、矩阵近似、Kullback-Leibler 散度最小化等)提出的,这使得直接比较变得困难。在我们统一的观点下,我们解构方法,明确它们基于哪些构建块。例如,Snelson 和 Ghahramani (2006 [13] [15] u = f ∗ \mathbf{u} = \mathbf{f}_* u = f ∗ X u X_{\mathbf{u}} X u

我们根据它们与相应的完整高斯过程的接近程度对近似进行了排名。然而,实际情况下的性能可能并不总是遵循这个理论排名,因为近似可能表现出可能特别适合特定数据集的属性(不存在于完整的高斯过程中)。这可能会使实证比较的解释具有挑战性。当添加必要的启发式方法以将理论结构转化为实际算法时,会出现更复杂的情况。我们没有在本文中描述完整的算法,但目前正在进行详细的实证研究(准备中,另请参见 Rasmussen 和 Williams,2006 年,第 8 章)。

我们注意到,对于所有考虑的方法,计算复杂度的顺序是相同的,O ( n m 2 ) \mathcal{O}(nm^2) O ( n m 2 )

我们在本文中只考虑了更简单的回归情况,但在分类设置中也普遍寻求稀疏性。将诸如期望传播 (EP) 或拉普拉斯方法(有关比较,参见 Kuss 和 Rasmussen,2005 年 [4]

我们的分析表明,将最佳可能近似 (PITC) 与最强大的归纳输入选择方法相结合会产生一种有趣的新近似。这将对应于 BCM 的非转换版本。我们将避免在进行大量计算之前了解测试集的必要性,并且我们希望能够取代 Snelson 和 Ghahramani(2006 年 [13]

参考文献

[1] Corinna Cortes and Vladimir Vapnik. Support-vector network. Machine Learning, 20(3):273–297, 1995. [2] Lehel Csato and Manfred Opper. Sparse online Gaussian processes. Neural Computation, 14(3): 641–669, 2002. [3] Sathiya Keerthi and Wei Chu. A Matching Pursuit approach to sparse Gaussian process regression. In Y. Weiss, B. Sch ̈ olkopf, and J. Platt, editors, Advances in Neural Information Processing Systems 18, Cambridge, Massachussetts, 2006. The MIT Press. [4] Malte Kuss and Carl Edward Rasmussen. Assessing approximate inference for binary Gaussian process classification. Journal of Machine Learning Research, pages 1679–1704, 2005. [5] Joaquin Quinonero-Candela. Learning with Uncertainty – Gaussian Processes and Relevance Vector Machines. PhD thesis, Technical University of Denmark, Lyngby, Denmark, 2004. [6] Carl Edward Rasmussen. Reduced rank Gaussian process learning. Technical report, Gatsby Computational Neuroscience Unit, UCL, 2002. [7] Carl Edward Rasmussen and Joaquin Qui ̃ nonero-Candela. Healing the relevance vector machine by augmentation. In International Conference on Machine Learning, 2005. [8] Carl Edward Rasmussen and Christopher K. I. Williams. Gaussian Processes for Machine Learning. The MIT press, 2006. [9] Anton Schwaighofer and Volker Tresp. Transductive and inductive methods for approximate Gaussian process regression. In Suzanna Becker, Sebastian Thrun, and Klaus Obermayer, editors, Advances in Neural Information Processing Systems 15, pages 953–960, Cambridge, Massachussetts, 2003. The MIT Press. [10] Matthias Seeger, Christopher K. I. Williams, and Neil Lawrence. Fast forward selection to speed up sparse Gaussian process regression. In Christopher M. Bishop and Brendan J. Frey, editors, Ninth International Workshop on Artificial Intelligence and Statistics. Society for Artificial Intelligence and Statistics, 2003. [11] Bernhard W. Silverman. Some aspects of the spline smoothing approach to non-parametric regression curve fitting. J. Roy. Stat. Soc. B, 47(1):1–52, 1985. (with discussion). [12] Alexander J. Smola and Peter L. Bartlett. Sparse greedy Gaussian process regression. In Todd K. Leen, Thomas G. Dietterich, and Volker Tresp, editors, Advances in Neural Information Processing Systems 13, pages 619–625, Cambridge, Massachussetts, 2001. The MIT Press. [13] Edward Snelson and Zoubin Ghahramani. Sparse Gaussian processes using pseudo-inputs. In Y. Weiss, B. Sch ̈ olkopf, and J. Platt, editors, Advances in Neural Information Processing Systems 18, Cambridge, Massachussetts, 2006. The MIT Press. [14] Michael E. Tipping. Sparse Bayesian learning and the Relevance Vector Machine. Journal of Machine Learning Research, 1:211–244, 2001. [15] Volker Tresp. A Bayesian committee machine. Neural Computation, 12(11):2719–2741, 2000. [16] Vladimir N. Vapnik. The Nature of Statistical Learning Theory. Springer Verlag, 1995. [17] Grace Wahba, Xiwu Lin, Fangyu Gao, Dong Xiang, Ronald Klein, and Barbara Klein. The biasvariance tradeoff and the randomized GACV. In Michael S. Kerns, Sara A. Solla, and David A. Cohn, editors, Advances in Neural Information Processing Systems 11, pages 620–626, Cambridge, Massachussetts, 1999. The MIT Press. [18] Christopher K. I. Williams and Carl Edward Rasmussen. Gaussian processes for regression. In David S. Touretzky, Michael C. Mozer, and Michael E. Hasselmo, editors, Advances in Neural Information Processing Systems 8, pages 514–520, Cambridge, Massachussetts, 1996. The MIT Press. [19] Christopher K. I. Williams, Carl Edward Rasmussen, Anton Schwaighofer, and Volker Tresp. Observations of the Nystr ̈ om method for Gaussiam process prediction. Technical report, University of Edinburgh, Edinburgh, Scotland, 2002. [20] Christopher K. I. Williams and Mathias Seeger. Using the Nystr ̈ om method to speed up kernel machines. In Todd K. Leen, Thomas G. Dietterich, and Volker Tresp, editors, Advances in Neural Information Processing Systems 13, pages 682–688, Cambridge, Massachussetts, 2001. The MIT Press. [21] David Wipf, Jason Palmer, and Bhaskar Rao. Perspectives on sparse Bayesian learning. In Sebastian Thrun, Lawrence Saul, and Bernhard Sch ̈ olkopf, editors, Advances in Neural Information Processing Systems 16, Cambridge, Massachussetts, 2004. The MIT Press.